Sponzorizat de newsflash.ro

Se poate rula local, pe Windows 11, un model LLM llama 3.1 fără să fie nevoie de cine știe ce configurație de gaming? Spre surprinderea mea, răspunsul e DA! Ai nevoie de un laptop Copilot+ – pentru că am în teste un Asus Vivobook S15 Snapdrgon X Elite, l-am pus pe el la treabă cu rezultate peste așteptări.

De când cu febra asta a AI-ului am început să mă uit și eu mai îndeaproape peste subiect, inclusiv să descarc local diverse LLM-uri și să încerc să le modific. Fără putere semnificativă de calcul, pe sisteme mai puțin performante soluții precum AI Studio merg extrem, extrem de greu, probabil știți asta. Practic e imposibil să le folosești dacă un ai un super CPU sau un GPU optimizat.

Doar că de când Microsoft împinge intens ideea de sistem Copilot+ pe platforma ARM, ca soluție eficientă de a rula AI-ul Copilot, dar numai cu Windows 11, lucrurile încep să se schimbe și pare că există aplicabilitate pentru procesoarele NPU, dincolo de integrarea cu Windows 11 și AI-ul Copilot.

Am în teste un laptop Asus Vivobook S15 Copilot+ ARM (cu Snapdragon X Elite) și zilele trecute am avut o revelație: dincolo de faptul că e ușor, are un super display și că platforma ARM îi permite o autonomie bună, cu o performanță excelentă, fără zgomot, acest laptop poate fi folosit și ca instrument de explorare a AI-ului folosind soluții dedicate.

AI în NPU cu rezultate în timp real

Cine a studiat puțin domeniul știe că pe piață sunt câteva IDE-uri care permit interacțiunea cu diversele modele ce pot fi descărcate gratuit. E însă nevoie de ceva putere de calcul ca să își facă treaba bine, mai ales dacă e explorată ideea de personalizare a AI-ului.

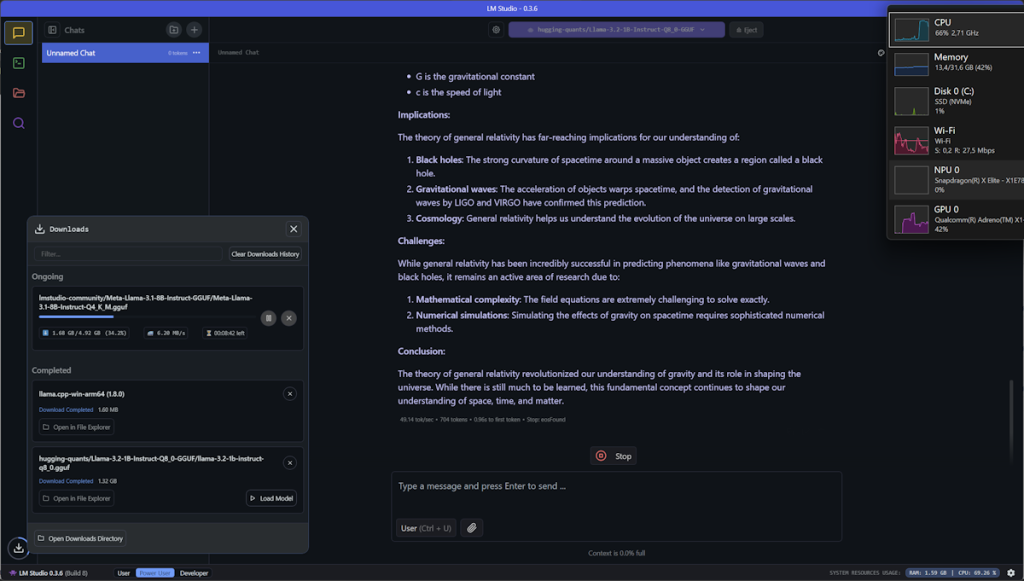

Pentru că LM Studio nu are implementat în varianta standard suportul pentru folosirea NPU-ului de pe sistemele Copilot+ ARM, folosirea sa pe un sistem Copilot+ ARM e puțin cam anevoioasă. Am văzut că se poate (Scott Hanselman a făcut un demo cu așa ceva acum vreo 2 luni), dar pentru moment se mișcă greu de tot. Răspunsul la întrebări ceva mai complexe (de exemplu rezolvarea unei probleme de matematică) e dat în câteva minute de LM Studio 0.3.6, folosind la maxim CPU-ul de pe un laptop Copilot+ ARM, cu tot cu un model optimizat.

Anything LLM cu suport NPU

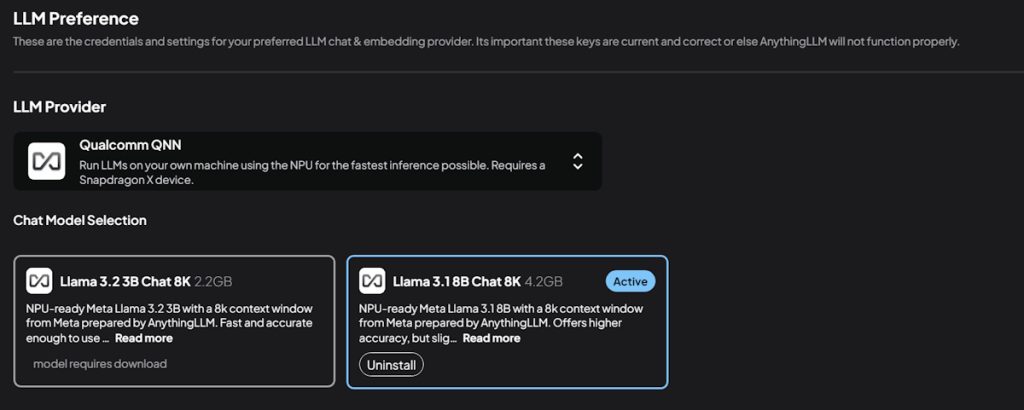

Căutând informații despre cum poți folosi modele LLM pe laptop-uri Copilot+ ARM care să pună în valoare NPU-ul am dat despre un anunț destul de proaspăt: IDE-ul AnythingLLM integrează Qualcomm QNN ce permite folosirea modelelor LLM cu suport NPU pe sisteme Snapdragon X, adică fix ceea ce am eu în Asus Vivobook S15.

L-am dat jos de aici, l-am instalat (atenție că e atât de nou încât Microsoft încă nu l-a adăugat în lista de programe valide și implicit o să vă blocheze instalarea!) și am…

Sponzorizat de newsflash.ro

Citeste continuarea pe www.mobzine.ro